Cómo se lleva a cabo la normalización de datos masivos

En la era del Big Data, donde la cantidad de información generada es abrumadora, la normalización de datos masivos se ha convertido en una práctica esencial para las organizaciones que buscan convertir datos brutos en un recurso valioso. La normalización no solo permite la consolidación y la simplificación de grandes volúmenes de información, sino que también garantiza la calidad, la coherencia y la integridad de los datos, que son fundamentales para tomar decisiones estratégicas respaldadas por evidencias sólidas.

A lo largo de este artículo, exploraremos en profundidad qué es la normalización de datos masivos, por qué es crucial en el análisis de datos, y cómo se lleva a cabo este proceso. A través del análisis de sus beneficios, los métodos empleados y los desafíos que se presentan, proporcionaremos una guía integral que será de gran utilidad tanto para profesionales del campo de la ciencia de datos como para cualquier persona interesada en entender mejor cómo se gestionan y optimizan los datos en grandes escalas.

¿Qué es la normalización de datos masivos?

La normalización de datos masivos se refiere al proceso de estructurar y organizar datos de manera que puedan ser utilizados eficientemente en análisis posteriores. Este proceso implica transformar datos crudos y no estructurados en un formato que esté estandarizado y sea comparable, lo que facilita su uso y análisis. En esencia, la normalización busca resolver problemas como la duplicación, la inconsistencia y los posibles conflictos de datos, lo que permite a las organizaciones realizar análisis más precisos y efectivos.

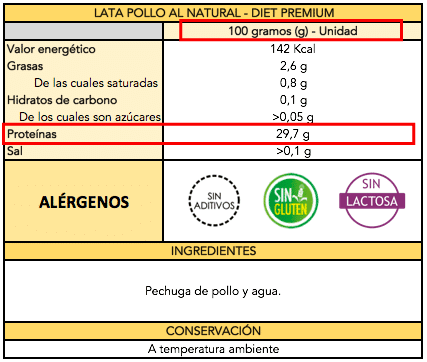

La normalización puede abarcar diversas dimensiones, incluyendo, pero no limitándose a, la eliminación de duplicados, la estandarización de formatos y la integración de datos provenientes de diferentes fuentes. Por ejemplo, si una organización recopila datos de diversas plataformas, es probable que encuentren variaciones en los nombres de clientes, direcciones o números de teléfono. La normalización permite unificar esta información para que sea coherente en todas las bases de datos.[

Importancia de la normalización de datos masivos

Entender la importancia de la normalización de datos es vital para cualquier entidad que trabaje con grandes volúmenes de información. En primer lugar, la normalización mejora la calidad de los datos. Datos de alta calidad son esenciales para la precisión de los análisis, y cualquier error o inconsistencia puede llevar a decisiones basadas en información incorrecta. Esto es particularmente crítico en sectores como la salud, las finanzas y el marketing, donde las decisiones pueden tener un impacto significativo.

Además, la normalización de datos facilita la interoperabilidad entre diferentes sistemas y plataformas. Al contar con un formato estandarizado, los datos pueden ser fácilmente compartidos y utilizados en diversas aplicaciones sin la necesidad de costosos y complejos procesos de transformación. Esto es especialmente útil en entornos empresariales donde la colaboración y el intercambio de información entre distintos departamentos es esencial para alcanzar objetivos comunes.

La normalización también permite un análisis más rápido y eficiente. Con datos organizados y coherentes, los analistas pueden acceder a la información que necesitan sin perder tiempo revisando datos desordenados o inconsistentes. Esto permite a las organizaciones ser más ágiles en su toma de decisiones, lo que puede ser una ventaja competitiva crucial en el dinámico entorno empresarial actual. La normalización no solo garantiza la calidad y consistencia de los datos, sino que también mejora la colaboración y la eficiencia operativa.

Métodos de normalización de datos masivos

Existen diversos métodos para llevar a cabo la normalización de datos masivos. Uno de estos métodos es la estandarización, que implica convertir los datos a un formato común. Por ejemplo, al trabajar con direcciones, se puede estandarizar el uso de abreviaturas y formatos (como "St" en lugar de "Street"). Esta práctica asegura que todas las direcciones tengan una estructura uniforme, lo que facilita la comparación y el análisis.

Otro método común de normalización es la deduplicación. Este proceso implica identificar y eliminar registros que contienen información duplicada. Esto es esencial, ya que las duplicaciones no solo ocupan espacio innecesario en las bases de datos, sino que también pueden llevar a análisis erróneos. Herramientas de software especializadas suelen ser utilizadas para detectar y resolver estos problemas de duplicación.

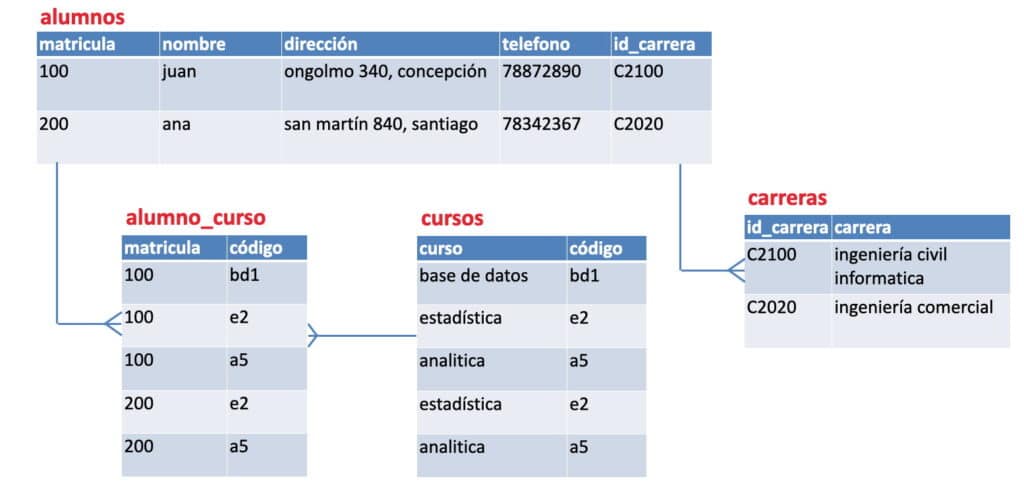

La integración de datos también es un aspecto clave en la normalización. Generalmente, las organizaciones recolectan datos de distintas fuentes, como encuestas en línea, formularios de registro y bases de datos externas. Integrar estos datos de manera coherente resulta fundamental para obtener una visión holística de la información. Esto implica que se deben tener en cuenta factores como coincidencias en campos, conversión de formatos y la armonización de diferentes sistemas de registro.

Desafíos en la normalización de datos masivos

A pesar de los múltiples beneficios que ofrece la normalización de datos, también existen desafíos significativos que deben ser superados. Uno de los principales obstáculos es la heterogeneidad de los datos. Esto se refiere al hecho de que datos provenientes de diferentes fuentes pueden tener estructuras y formatos muy diferentes. Esta variabilidad puede complicar la normalización y requerir técnicas avanzadas de procesamiento y análisis para lograr una integración adecuada.

Otro desafío se presenta en la escala del proceso. Normalizar enormes volúmenes de datos puede ser una tarea que demande mucho tiempo y recursos. Con el crecimiento del Big Data, las organizaciones deben asegurarse de contar con las herramientas y el personal capacitado para manejar la cantidad de información que deben procesar. Es aquí donde juega un papel crucial la automatización y el uso de inteligencia artificial para optimizar estos procesos y hacer que la normalización sea más eficiente.

Además, la privacidad y seguridad de los datos son temas a tener en cuenta durante la normalización. Es esencial que las organizaciones implementen políticas robustas para proteger la información sensible durante el proceso de normalización y asegurarse de cumplir con las normativas de protección de datos existentes. Esto no solo es crítico para la reputación de la empresa, sino que también es un requisito legal en muchos mercados.

El futuro de la normalización de datos masivos

El futuro de la normalización de datos masivos parece prometedor, especialmente con la evolución constante de la tecnología. Se están desarrollando herramientas cada vez más avanzadas que utilizan algoritmos de aprendizaje automático para facilitar el proceso de normalización. Estas herramientas pueden identificar patrones y tendencias en los datos, lo que mejora la calidad y precisión del proceso de normalización.

Además, a medida que más empresas adopten enfoques centrados en los datos, la demanda de procesos de normalización eficientes seguirá creciendo. La normalización no solo será esencial para el análisis de datos, sino que también jugará un papel clave en la toma de decisiones estratégicas, la mejora de productos y servicios y en la creación de experiencias más personalizadas para los clientes.

A medida que avanzamos hacia un mundo impulsado por datos, la normalización de datos masivos seguirá siendo una práctica fundamental para garantizar que las organizaciones aprovechen al máximo sus recursos de información. Aquellas que inviertan en procesos de normalización de calidad estarán mejor posicionadas para adaptarse a los cambios y aprovechar las oportunidades que surjan en el futuro.

Conclusión

La normalización de datos masivos es un componente vital en el manejo eficiente de datos en un mundo donde la información se genera a un ritmo acelerado. Este proceso no solo mejora la calidad y la consistencia de los datos, sino que también garantiza que las organizaciones puedan realizar análisis precisos, colaborar eficazmente y tomar decisiones informadas. A medida que la tecnología evoluciona y los volúmenes de datos continúan creciendo, la normalización se convierte en una necesidad indispensable. Con una adecuada implementación de métodos y herramientas de normalización, las empresas no solo optimizarán sus procesos de datos, sino que también estarán mejor preparadas para enfrentar los desafíos futuros y aprovechar las oportunidades que ofrece el Big Data.

Si quieres conocer otros artículos parecidos a Cómo se lleva a cabo la normalización de datos masivos puedes visitar la categoría Datos.

Deja una respuesta