Construcción de pipelines de datos en proyectos bioinformáticos

La bioinformática ha emergido como un campo esencial en la investigación biológica moderna, combinando la biología, la informática y las matemáticas para analizar grandes conjuntos de datos biológicos. En este contexto, la construcción de pipelines de datos se convierte en una herramienta crucial para transformar estos datos sin procesar en información útil que facilite la toma de decisiones en investigaciones y tratamientos médicos. Este artículo profundizará en la importancia de los pipelines de datos en proyectos bioinformáticos y la forma en que su diseño y construcción impactan en los resultados de la investigación.

A lo largo de este artículo, exploraremos qué son los pipelines de datos, cómo se construyen y cuál es su relevancia en el ámbito bioinformático. Así mismo, abordaremos las tecnologías y herramientas disponibles para su construcción, así como los desafíos que pueden surgir en el proceso. Al final, esperamos ofrecer una visión clara y comprensible sobre cómo implementar estos sistemas en proyectos bioinformáticos, enfatizando su impacto en la investigación actual y futura.

- ¿Qué son los pipelines de datos?

- La importancia de los pipelines de datos en bioinformática

- Construcción de un pipeline de datos: etapas clave

- Herramientas y tecnologías para la construcción de pipelines de datos

- Desafíos en la construcción de pipelines de datos

- Reflexiones finales y oportunidades futuras

¿Qué son los pipelines de datos?

Los pipelines de datos son conjuntos secuenciales de procesos utilizados para transformar, procesar y analizar datos de manera eficiente. En términos simples, un pipeline es un flujo de trabajo que permite a los investigadores y científicos de datos automatizar la manipulación y el análisis de datos, permitiendo que se realicen tareas complejas con un mínimo de intervención manual. En el contexto de la bioinformática, estos pipelines son esenciales para gestionar grandes volúmenes de datos biológicos, como información genómica, proteómica y metabolómica.

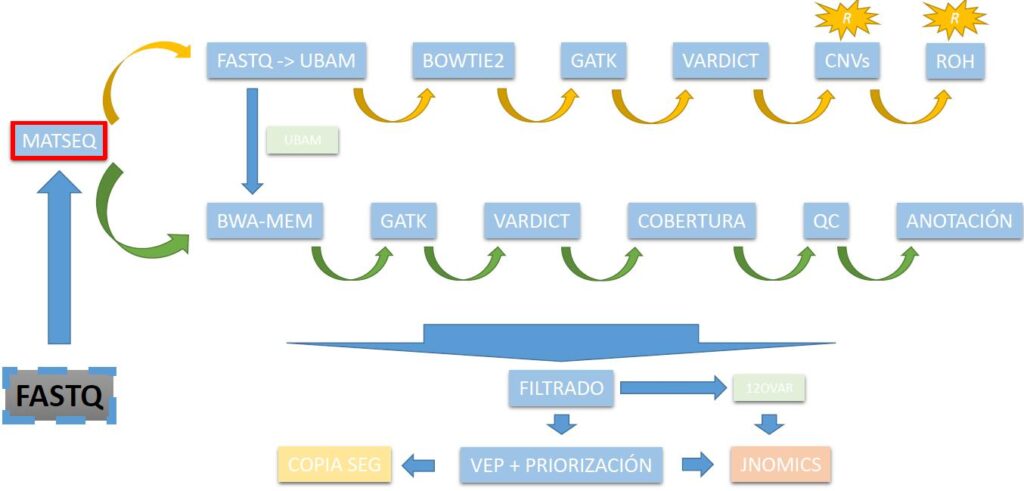

El funcionamiento de un pipeline de datos típicamente involucra varias etapas, que pueden incluir la ingesta de datos, la limpieza de datos, el análisis, la visualización y la interpretación de los resultados. Por ejemplo, en la secuenciación de ADN, los datos brutos generados por los secuenciadores deben ser procesados para eliminar errores, alinearse con genomas de referencia y finalmente ser analizados para identificar variantes genéticas. Este proceso es altamente especializado y, sin un pipeline adecuado, podría convertirse en una tarea monumental y propensa a errores.

La importancia de los pipelines de datos en bioinformática

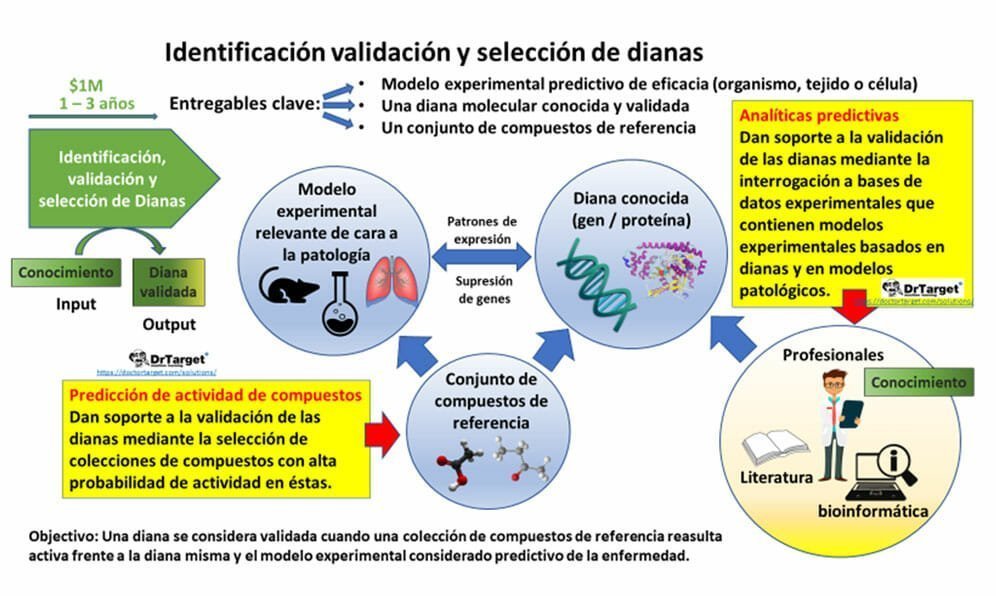

La bioinformática es un campo en constante crecimiento y evolución, especialmente con la explosionante cantidad de datos biológicos generados cada día. El uso de pipelines de datos no solo acelera este proceso, sino que también permite a los investigadores realizar análisis más precisos y reproducibles. Además, el establecimiento de un pipeline de datos robusto es fundamental para garantizar que los resultados obtenidos sean válidos y fiables. Esto se vuelve particularmente crítico en aplicaciones clínicas, donde los errores pueden tener consecuencias importantes.

Uno de los beneficios más significativos de implementar un pipeline de datos es la capacidad de mantener la trazabilidad y la transparencia en los procesos de análisis. Esto es crucial no solo para la validación de resultados, sino también para cumplir con los estándares éticos y regulativos que rigen la investigación biomédica. Al ofrecer un registro claro y reproducible de cada paso en el proceso, los pipelines facilitan la revisión por pares y la replicación de estudios, ayudando a construir confianza en los hallazgos científicos.

Construcción de un pipeline de datos: etapas clave

La construcción de un pipeline de datos en proyectos bioinformáticos puede dividirse en varias etapas esenciales. Cada una de estas etapas desempeña un papel crucial en la preparación y el análisis de los datos biológicos. A continuación, exploraremos cada etapa en detalle, enfatizando las mejores prácticas y consideraciones que deben tenerse en cuenta.

La primera etapa en la construcción de un pipeline es la ingesta de datos, que implica la recopilación y almacenamiento de datos biológicos. Durante esta fase, los investigadores deben considerar no solo la fuente de los datos, sino también su formato y calidad. Es esencial utilizar formatos estandarizados y asegurarse de que los datos hayan sido validados antes de incorporarlos al pipeline.

Una vez que los datos han sido recopilados, el siguiente paso es la limpieza de datos. Esta etapa es fundamental, ya que los datos biológicos pueden contener errores debido a diversas causas, como la calidad de los experimentos, las condiciones de laboratorio o los instrumentos utilizados. Durante la limpieza de datos, se deben identificar y corregir inconsistencias, así como eliminar datos duplicados o irrelevantes para garantizar que solo se utilicen datos de alta calidad en el análisis posterior.

El tercer paso es el análisis de datos, donde se aplican diferentes algoritmos y herramientas bioinformáticas para extraer información significativa de los datos limpios. Este proceso puede incluir actividades como alineación de secuencias, ensamblado de genomas y análisis de expresión génica. La selección adecuada de herramientas y métodos es crucial en esta etapa, ya que afectará la calidad de los resultados obtenidos.

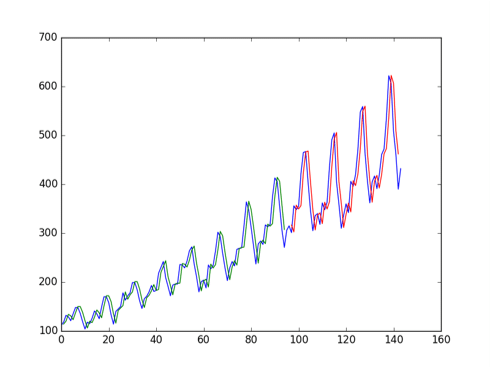

Después del análisis, los resultados deben ser sometidos a una visualización de datos. Esta etapa permite a los investigadores interpretar los resultados de manera efectiva, utilizando gráficos y visualizaciones que faciliten la comprensión de patrones y hallazgos. La capacidad de visualizar datos complejos de manera intuitiva es vital para comunicar los resultados a otros investigadores y partes interesadas.

Finalmente, la última etapa de un pipeline de datos implica la interpretación de resultados. Aquí, los investigadores deben integrar los hallazgos en el contexto más amplio de sus preguntas de investigación y objetivos científicos. Además, es importante documentar cada paso del proceso para garantizar la reproducibilidad y la transparencia en la investigación.

Herramientas y tecnologías para la construcción de pipelines de datos

La construcción de un pipeline de datos efectivo requiere el uso de diversas herramientas y tecnologías que permiten realizar las diferentes etapas del proceso de manera eficiente. En la actualidad, existen múltiples opciones disponibles que pueden adaptarse a las necesidades específicas de cada proyecto bioinformático.

En primer lugar, los lenguajes de programación como Python y R son ampliamente utilizados en la bioinformática por su flexibilidad y la variedad de bibliotecas científicas que ofrecen. Python, en particular, es popular por su sintaxis sencilla y su amplia gama de herramientas de análisis de datos como Pandas, NumPy y SciPy. Por otro lado, R es especialmente fuerte en estadísticas y visualización de datos, siendo una opción preferida por muchos investigadores en este campo.

Además, se han desarrollado plataformas y frameworks específicos para la construcción de pipelines de datos. Herramientas como Snakemake y Nextflow permiten a los investigadores definir flujos de trabajo de manera declarativa, facilitando la gestión de tareas y dependencias entre ellas. Estas herramientas no solo simplifican la construcción de pipelines, sino que también proporcionan funcionalidades para ejecutar los análisis en entornos diversos, desde ordenadores personales hasta clústeres de computación de alto rendimiento.

En el ámbito de la visualización de datos, plataformas como Tableau y ggplot2 en R son altamente valoradas por su capacidad para convertir datos complejos en visualizaciones interactivas y comprensibles. Esto es fundamental para la interpretación de resultados y la comunicación efectiva de los hallazgos a audiencias tanto técnicas como no técnicas.

Desafíos en la construcción de pipelines de datos

Pese a los numerosos beneficios de implementar pipelines de datos, también existen desafíos significativos que los investigadores deben considerar. Uno de los principales obstáculos es la interoperabilidad de datos. Dado que los datos biológicos pueden provenir de diversas fuentes y estar en diferentes formatos, es crucial que el pipeline pueda manejar estas variabilidades. Esto a menudo requiere el uso de herramientas de conversión de datos y estándares que aseguren que todos los conjuntos de datos sean compatibles.

Otro desafío es la escalabilidad. A medida que la cantidad de datos biológicos continúa creciendo, es fundamental que los pipelines sean capaces de manejar volúmenes cada vez mayores de información. Esto implica diseñar sistemas que no solo sean eficientes en términos de ejecución, sino que también puedan adaptarse a la creciente demanda de procesamiento de datos en el futuro.

Finalmente, la gestión de errores es un aspecto crucial que los investigadores deben abordar. Dado que el procesamiento de datos biológicos puede ser propenso a errores, es vital establecer mecanismos de control de calidad y validación en cada etapa del pipeline. Esto no solo ayuda a prevenir errores, sino que también contribuye a la confianza en los resultados obtenidos.

Reflexiones finales y oportunidades futuras

A medida que los avances tecnológicos continúan transformando el campo de la bioinformática, la construcción de pipelines de datos se hace imprescindible para maximizar la eficiencia y la precisión en el análisis de datos biológicos. A través de la creación de flujos de trabajo automatizados y reproducibles, los investigadores pueden centrarse en la interpretación y aplicación de los resultados, en lugar de perder tiempo en tareas manuales.

La continua innovación en herramientas y enfoques para la construcción de pipelines de datos abrirá nuevas oportunidades en la investigación biomédica y genómica. Se espera que, en los próximos años, una mayor integración de tecnologías emergentes, como la inteligencia artificial y el aprendizaje automático, transforme aún más la manera en que se manejan y analizan los datos bioinformáticos. La implementación efectiva de pipelines de datos no solo es un desafío, sino también una puerta abierta a un futuro de descubrimientos significativos en el campo de la biología y la medicina, ofreciendo a los investigadores herramientas potentes para avanzar en sus proyectos y contribuir a la comprensión de la vida a nivel molecular.

Si quieres conocer otros artículos parecidos a Construcción de pipelines de datos en proyectos bioinformáticos puedes visitar la categoría Machine Learning.

Deja una respuesta