Guía para implementar pipelines eficientes en CWL fácilmente

En la actual era de los datos, la necesidad de herramientas que faciliten el procesamiento y análisis de grandes volúmenes de información es más crucial que nunca. La integración de flujos de trabajo automáticos se ha convertido en una prioridad para investigadores y profesionales en múltiples disciplinas, desde la bioinformática hasta la computación en la nube. En este contexto, uno de los estándares más destacados es el Common Workflow Language (CWL), que permite la creación de **pipelines** reproducibles y eficientes. La eficiencia y la reutilización son esenciales para maximizar la productividad, y esta guía se propone desglosar cómo lograr una implementación efectiva de pipelines en CWL.

Este artículo se sumergirá en el mundo de CWL, analizando sus componentes, características y pasos necesarios para desarrollar **pipelines** que optimizan la ejecución de tareas complejas. Desde la instalación de las herramientas requeridas hasta ejemplos prácticos de implementación, cubriremos todos los aspectos relevantes para que tanto principiantes como experimentados en la materia puedan sacar provecho de esta poderosa herramienta. Con el objetivo de establecer una base sólida en el uso de CWL, abordaremos cada tema con gran profundidad y detalle, garantizando así que los lectores cuenten con la información necesaria para poner en práctica lo aprendido.

¿Qué es el Common Workflow Language (CWL)?

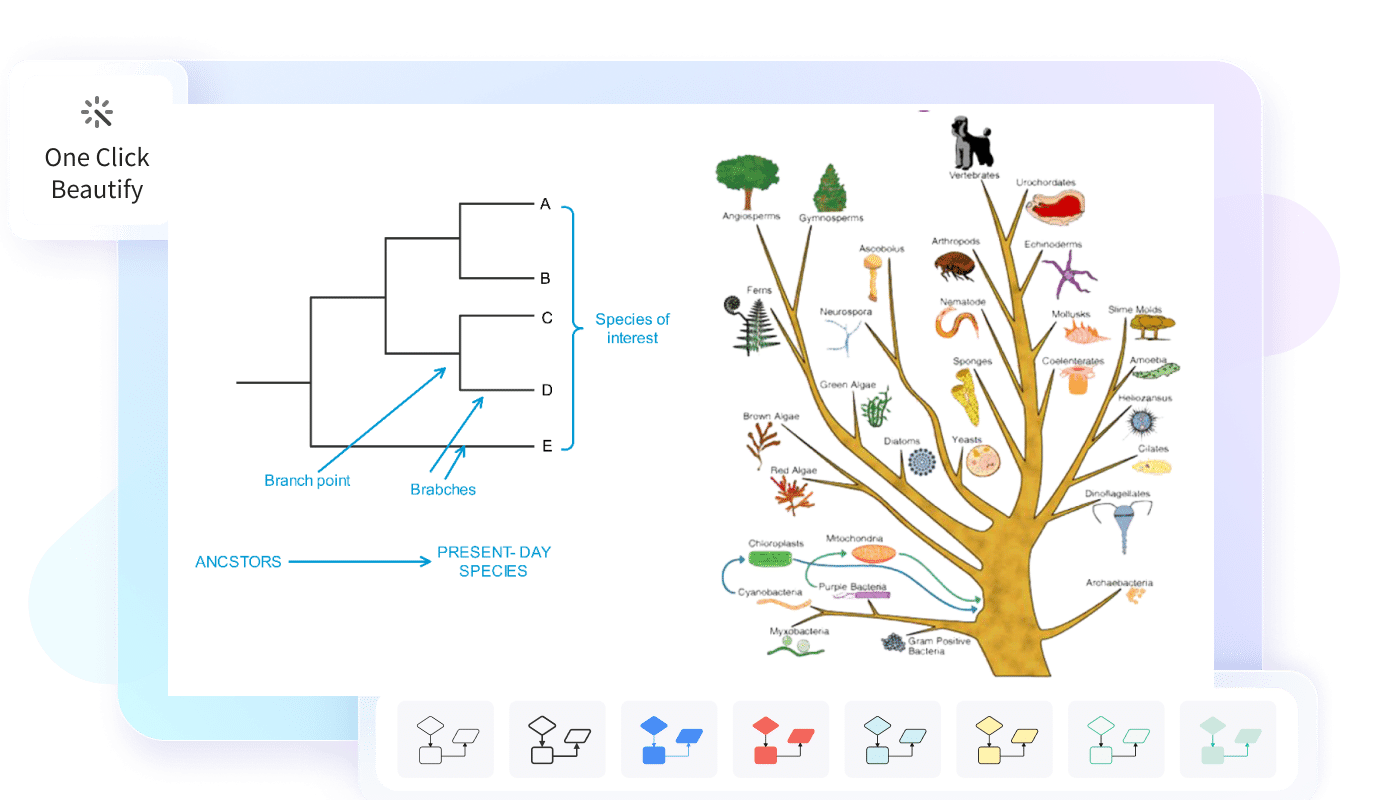

El **Common Workflow Language**, o CWL, es un estándar abierto diseñado para describir y reproducir flujos de trabajo en computación científica. Este lenguaje se enfoca en proporcionar descripciones precisas de tareas y su lógica de ejecución, lo que permite que diferentes herramientas puedan interoperar sin problemas. CWL ha ganado popularidad debido a su capacidad de definir no solo el flujo de procesos, sino también las entradas y salidas de cada tarea. Esto es especialmente significativo en el contexto de análisis de datos, donde las dependencias entre tareas y el manejo de resultados son vitales.

La principal ventaja de utilizar **CWL** reside en su compatibilidad con una amplia gama de herramientas y plataformas, lo que facilita la integración de diferentes componentes en un mismo flujo de trabajo. Además, al ser un lenguaje declarativo, permite a los científicos y desarrolladores centrarse en lo que desean lograr sin tener que preocuparse por los detalles de implementación de cada herramienta individualmente. Por lo tanto, el CWL se convierte en una opción preferida para aquellos que buscan una solución escalable y versátil en la creación de pipelines.

Componentes fundamentales de un pipeline en CWL

Crear un pipeline en CWL implica comprender sus componentes clave, que son esenciales para su funcionamiento efectivo. Cada pipeline está compuesto por **jobs**, que representan las unidades de trabajo; **requirements**, que especifican las condiciones que deben cumplirse para ejecutar un job; y **inputs/outputs**, que definen qué datos se requieren y qué datos se generarán en cada etapa del flujo de trabajo.

Un **job** se compone de un comando o script que se ejecuta sobre un conjunto de datos de entrada y produce resultados como salida. En CWL, los inputs pueden ser parámetros, archivos de datos o cualquier otra información necesaria para que el job se ejecute correctamente. Por su parte, los outputs son los resultados generados por el trabajo, que pueden ser utilizados por trabajos futuros, formando así una red de dependencias entre diversos componentes del flujo de trabajo.

Los **requirements** también son esenciales, ya que permiten especificar los entornos de ejecución necesarios para cada trabajo. Esto incluye configuraciones relacionadas con el sistema operativo, recursos computacionales, herramientas necesarias y otros aspectos que puedan influir en la ejecución de los jobs. Entender cómo interactúan estos componentes es clave para construir un pipeline eficiente y robusto en CWL, lo que nos permitirá avanzar hacia la siguiente fase de implementación.

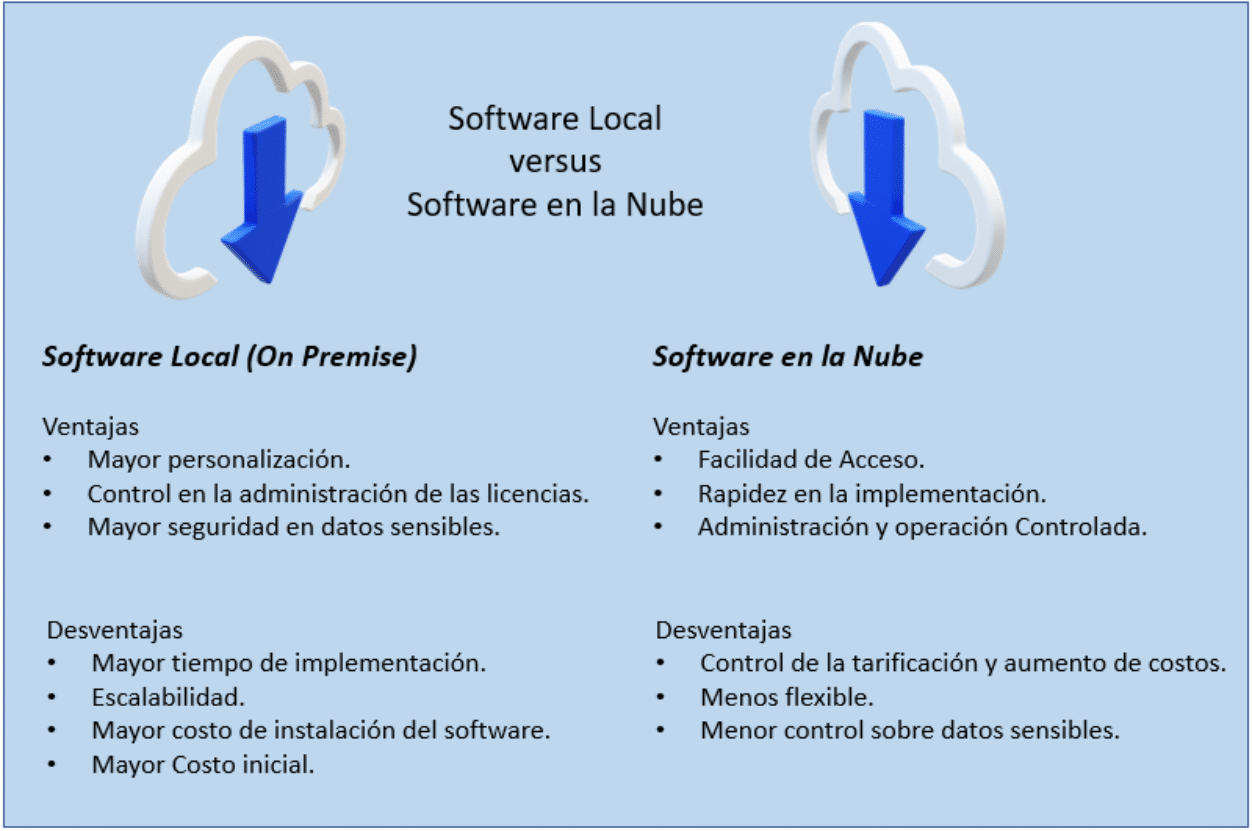

Configuración del entorno de trabajo para CWL

Antes de sumergirse en el desarrollo de **pipelines** en CWL, es crucial establecer un entorno de trabajo adecuado que garantice un funcionamiento suave y efectivo. La configuración del entorno implica la instalación de herramientas adicionales como un motor de ejecución de CWL, por ejemplo, *cwltool* o *Toil*, que facilitan la ejecución de los flujos de trabajo descritos. Además, se deberá contar con un sistema que permita manejar los datos de entrada y salida de manera eficiente.

El primer paso en esta configuración es instalar CWL. Esto se puede hacer fácilmente utilizando *pip*, el gestor de paquetes de Python. Ejecutar el comando pip install cwltool es suficiente para instalar la herramienta. Una vez instalada, es posible probar la configuración ejecutando ejemplos básicos y asegurándose de que el sistema funcione correctamente antes de avanzar hacia la creación de **pipelines** más complejos.

Además de instalar el motor de ejecución, es recomendable familiarizarse con diferentes herramientas de línea de comandos que puedan ser útiles en el contexto de análisis de datos. Tener un buen dominio de shell scripting y sistemas de gestión de versiones como *Git* también puede ser beneficioso, ya que esto permitirá una mejor administración de versiones de los diferentes componentes que se vayan desarrollando dentro del pipeline.

Creación de un pipeline básico en CWL

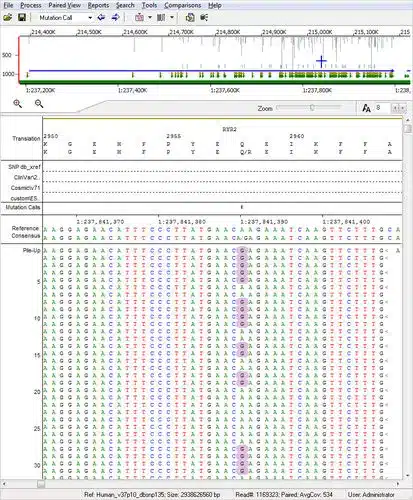

Una vez configurado el entorno, el siguiente paso es empezar a crear un pipeline básico en CWL. Para ello, se requiere definir una estructura de archivo que abarque tanto la descripción de los trabajos como sus interconexiones. Comencemos considerando un flujo de trabajo simple que realice un análisis básico de datos de secuenciación.

El primer paso es crear un archivo YAML que describa nuestro flujo de trabajo. Este archivo contendrá definiciones para los pasos involucrados, como la preparación de datos, el análisis y la generación de resultados. Dentro del archivo, cada job se describirá con sus respectivos inputs, outputs y el comando que ejecutará. Por ejemplo, podríamos tener un job para la alineación de secuencias que requiera un archivo de entrada y genere un archivo de salida de alineación.

Es crucial que también se definan los tipos de datos exactos para cada input y output, ya que esto permite a CWL asegurarse de que los datos fluyan correctamente entre los diferentes trabajos. La creación de este pipeline requerirá pruebas y ajustes, por lo que es recomendable ejecutar el pipeline tras cada cambio mayor para verificar que todo funcione de acuerdo a lo esperado.

Depuración y optimización de pipelines en CWL

La depuración de un **pipeline** en CWL puede ser una tarea desafiante, sobre todo a medida que el flujo de trabajo se vuelve más complejo. Sin embargo, CWL proporciona herramientas útiles para la depuración y optimización de flujos de trabajo. Las salidas de error y las trazas de seguimiento pueden ayudar a identificar problemas, permitiendo que los desarrolladores realicen los ajustes necesarios. Además, utilizar un motor de ejecución que soporte ejecución paralela puede resultar en un aumento significativo en la velocidad de procesamiento de datos.

La optimización también implica tener en cuenta la eficiencia de los datos, evitando redundancias y facilitando un tránsito ágil de datos a través de los trabajos. A menudo, es posible que ciertos trabajos compartan salida o manejo de datos, planteando así la necesidad de ajustar el flujo para maximizar el uso de la memoria y el almacenamiento. Asimismo, el uso de contenedores como Docker puede ser muy beneficioso, ya que permite encapsular los entornos de cada job, asegurando que todas las dependencias sean atendidas adecuadamente.

Conclusión

Implementar **pipelines** eficientes en CWL es una habilidad que puede transformar significativamente la forma en que manejamos y procesamos datos complejos. Desde la comprensión de los componentes fundamentales hasta la depuración y optimización de los flujos de trabajo, cada paso es fundamental para lograr una ejecución exitosa y reproducible. CWL no solo ayuda en la integración de diferentes herramientas, sino que también promueve prácticas recomendadas en el manejo de datos y flujos de trabajo científicos.

Al invertir tiempo en la creación y refinamiento de **pipelines** en CWL, se logrará una mayor agilidad en el procesamiento de datos, lo que abre la puerta a investigaciones más profundas y análisis más precisos. La transición hacia la adopción de estándares como CWL es fundamental para cualquier profesional que busque mejorar la eficiencia y reproducibilidad de sus investigaciones, asegurando que los beneficios de la ciencia de datos y la computación en la nube se maximicen en cada proyecto.

Si quieres conocer otros artículos parecidos a Guía para implementar pipelines eficientes en CWL fácilmente puedes visitar la categoría Software.

Deja una respuesta