Herramientas de aprendizaje automático para análisis de datos

El aprendizaje automático ha emergido como una de las tecnologías más innovadoras y poderosas de la era digital, transformando la manera en que las empresas y los individuos analizan y procesan datos. A medida que el volumen de datos generados cada día crece exponencialmente, la necesidad de contar con herramientas efectivas que faciliten el análisis se ha vuelto imperante. El uso de algoritmos y técnicas de machine learning permite a los analistas identificar patrones, hacer predicciones y tomar decisiones informadas basadas en datos, lo que resulta fundamental en un ecosistema liderado por la información.

Este artículo se propone explorar en profundidad las distintas herramientas de aprendizaje automático disponibles para el análisis de datos, abarcando desde plataformas de software hasta bibliotecas de programación. Nos adentraremos en sus características, aplicaciones prácticas y beneficios, y ayudaremos a los lectores a comprender cómo estas soluciones pueden integrarse en sus propios flujos de trabajo. A lo largo del texto, ofreceremos ejemplos claros y consejos prácticos para maximizar el uso de estas herramientas en el análisis de datos.

¿Qué es el aprendizaje automático y por qué es crucial para el análisis de datos?

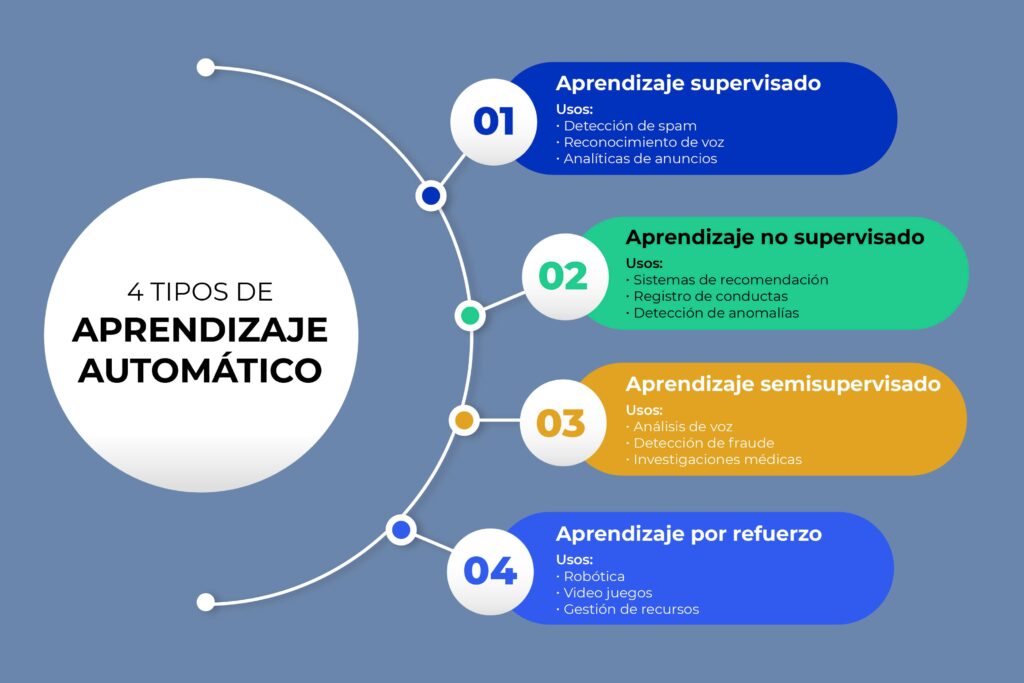

El aprendizaje automático, una rama de la inteligencia artificial, se enfoca en el desarrollo de algoritmos que permiten a las computadoras aprender de datos y realizar predicciones o clasificaciones sin ser programadas explícitamente para ello. Esta capacidad de aprender y generalizar es lo que hace que el aprendizaje automático sea una herramienta tan poderosa en el análisis de datos. En un contexto empresarial, permite a las empresas descubrir insights valiosos, optimizar procesos y mejorar la experiencia del cliente.

Por ejemplo, en el ámbito del comercio electrónico, las empresas pueden utilizar aprendizaje automático para analizar los comportamientos de compra y ofrecer recomendaciones personalizadas. Además, puede ayudar en la detección de fraudes al analizar transacciones en tiempo real. Con esto, podemos concluir que el aprendizaje automático no solo permite a los analistas acceder a información más profunda, sino que también transforma la manera en que se toman decisiones basadas en datos.

Principales herramientas de aprendizaje automático para el análisis de datos

Existen numerosas herramientas de aprendizaje automático que se utilizan en el análisis de datos, cada una con sus características y ventajas particulares. Estas herramientas pueden clasificarse en varias categorías, como lenguajes de programación, bibliotecas de código, plataformas de visualización y entornos de desarrollo integrados. A continuación, analizaremos algunas de las más populares y sus aplicaciones en el análisis de datos.

1. Python y sus bibliotecas de aprendizaje automático

Python se ha convertido en uno de los lenguajes de programación más utilizados para el análisis de datos y el aprendizaje automático, gracias a su simplicidad y versatilidad. Dentro de este lenguaje, existen varias bibliotecas que son fundamentales para implementar técnicas de aprendizaje automático. Algunas de las más notables son Scikit-learn, TensorFlow y Keras.

Scikit-learn ofrece una implementación de gran cantidad de algoritmos de aprendizaje supervisado y no supervisado, permitiendo a los usuarios entrenar modelos de manera sencilla y efectiva. Es ideal para quienes comienzan en el aprendizaje automático, ya que su documentación es clara y accesible.

TensorFlow, desarrollado por Google, es otra biblioteca que permite la creación de modelos de aprendizaje profundo. Es especialmente potente en tareas que requieren redes neuronales y en la manipulación de grandes volúmenes de datos. Junto a Keras, que actúa como una interfaz más amigable sobre TensorFlow, se convierte en una opción predilecta para investigadores y desarrolladores de machine learning.

2. R y sus capacidades en aprendizaje automático

R es un lenguaje especializado en estadísticas y análisis de datos, ofreciendo un ecosistema robusto para el aprendizaje automático. Las bibliotecas como caret y randomForest son ampliamente utilizadas para construir modelos predictivos. caret (Classification And REgression Training) proporciona una interfaz única para realizar tareas de preprocesamiento, selección de modelos y validación cruzada. Su enfoque en la estadística lo convierte en una opción ideal para analistas de datos que buscan realizar un análisis riguroso.

Por otro lado, randomForest es un algoritmo específico que permite crear árboles de decisión múltiple, lo que facilita la clasificación y regresión de datos complejos. La combinación de estas capacidades hace de R una herramienta esencial para aquellos que desean sumergirse en el análisis profundo de datos.

3. Plataformas de aprendizaje automático en la nube

El auge de la computación en la nube ha dado lugar a plataformas de aprendizaje automático que simplifican el proceso de creación y despliegue de modelos. Empresas como AWS (Amazon Web Services), Google Cloud AI y Microsoft Azure ofrecen servicios que permiten a los usuarios acceder a herramientas de machine learning sin necesidad de contar con infraestructura propia o conocimientos técnicos avanzados.

AWS, por ejemplo, proporciona Amazon SageMaker, una plataforma que facilita la construcción, entrenamiento y despliegue de modelos de aprendizaje automático. La capacidad de escalar y gestionar recursos en la nube hace que este tipo de plataforma sea extremadamente conveniente para las empresas de cualquier tamaño.

Del mismo modo, Google Cloud AI ofrece diversas APIs de inteligencia artificial que pueden ser utilizadas para reconocimiento de imágenes, procesamiento de lenguaje natural y más. La facilidad de integración de estas APIs en aplicaciones existentes permite a las empresas incorporar aprendizaje automático de manera rápida y efectiva.

4. Herramientas de visualización para el análisis de datos

Una parte clave del análisis de datos es la capacidad para visualizar resultados e insights de manera clara y efectiva. Herramientas como Tableau, Power BI y Matplotlib en Python, entre otras, permiten a los analistas presentar sus hallazgos en formatos visuales. Esto no solo facilita la comprensión, sino que también permite a las partes interesadas tomar decisiones informadas basadas en datos.

Tableau es conocido por su capacidad para crear visualizaciones interactivas que pueden ser compartidas fácilmente con otros. Por otro lado, Power BI, de Microsoft, permite integrar datos de diversas fuentes y crear informes dinámicos. En el ámbito de Python, Matplotlib ofrece una forma flexible de crear gráficos y visualizaciones, aumentando la versatilidad del lenguaje en el campo del análisis de datos.

Ventajas de utilizar herramientas de aprendizaje automático en el análisis de datos

Integra múltiples beneficios al utilizar herramientas de aprendizaje automático en el análisis de datos. En primer lugar, estas herramientas permiten procesar grandes volúmenes de información con rapidez y precisión, algo que sería inviable hacer manualmente. Además, el aprendizaje automático es capaz de identificar patrones complejos que pueden pasar desapercibidos para los seres humanos.

Otra ventaja significativa es la capacidad de realizar predicciones basadas en datos históricos. Esto es especialmente valioso en contextos como el análisis de tendencias de ventas o predecir el comportamiento del cliente. Al automatizar procesos analíticos, las empresas pueden centrarse en la toma de decisiones, en lugar de en tareas repetitivas.

Desafíos y consideraciones al implementar aprendizaje automático

A pesar de sus numerosas ventajas, el aprendizaje automático también presenta desafíos. Uno de los principales es la necesidad de datos de alta calidad. Los modelos de machine learning son tan buenos como los datos que los alimentan, por lo que es esencial dedicar tiempo a la limpieza y preprocesamiento de los datos antes de construir modelos.

Otro desafío significativo es la interpretabilidad de los modelos. Aunque los algoritmos de aprendizaje profundo, por ejemplo, son muy potentes, a menudo se comportan como "cajas negras", lo que significa que resulta complicado entender cómo llegan a sus conclusiones. Esto puede ser un obstáculo en situaciones donde la transparencia es crítica.

Conclusiones finales sobre las herramientas de aprendizaje automático para análisis de datos

Las herramientas de aprendizaje automático desempeñan un papel vital en la evolución del análisis de datos. Desde bibliotecas en lenguajes de programación como Python y R hasta plataformas en la nube, estas soluciones permiten a las empresas y analistas explorar datos de manera más eficiente y efectiva. A medida que el aprendizaje automático continúa avanzando, su influencia en el mundo del análisis de datos solo se hará más profunda.

La capacidad de descubrir insights a partir de datos masivos, hacer predicciones precisas y optimizar decisiones basadas en evidencias son solo algunas de las razones por las que el aprendizaje automático se está volviendo indispensable en el entorno empresarial moderno. Sin embargo, es primordial abordar los desafíos asociados con la implementación de estas herramientas para maximizar su efectividad. Con la combinación correcta de herramientas y un enfoque estratégico, las empresas pueden estar mejor equipadas para navegar el futuro del análisis de datos y aprovechar al máximo el potencial del aprendizaje automático.

Si quieres conocer otros artículos parecidos a Herramientas de aprendizaje automático para análisis de datos puedes visitar la categoría Farmacogenómica.

Deja una respuesta