Medición de la precisión en resultados de Machine Learning

En la era actual de la inteligencia artificial y el machine learning, la capacidad de crear modelos predictivos eficientes es crucial para diversas industrias. Desde la salud hasta las finanzas, entender cómo medir la precisión en los resultados de estos modelos puede marcar la diferencia entre el éxito y el fracaso de un proyecto. Este conocimiento no solo es fundamental para mejorar la calidad de los modelos, sino también para evaluar su rendimiento en situaciones del mundo real.

Este artículo se centrará en la medición de la precisión en los resultados de machine learning, explorando las principales métricas utilizadas, los enfoques para la evaluación, y la interpretación de los resultados. Definiremos conceptos clave, analizaremos ejemplos prácticos y ofreceremos una guía completa para ayudarte a entender cómo estas métricas pueden ser aplicadas en tu trabajo diario, ya sea que seas un profesional experimentado o un principiante en el campo.

Comprendiendo la precisión en machine learning

La precisión en el contexto de machine learning se refiere a la capacidad de un modelo para hacer predicciones correctas sobre un conjunto de datos. Por definición, un modelo se considera preciso si sus predicciones se alinean con los resultados reales. Sin embargo, la medición de la precisión no es un concepto único y puede variar en función del tipo de problema y del tipo de datos con los cuales se está trabajando.

En machine learning, hay una variedad de situaciones y algoritmos que requieren diferentes formas de medir la precisión. Por ejemplo, en problemas de clasificación, donde los modelos deben prever categorías discretas, métricas como la exactitud, la precisión, el recall, y la F1-score son esenciales para evaluar el rendimiento del modelo. En cambio, en problemas de regresión, donde el objetivo es predecir valores continuos, se utilizan métricas como el error cuadrático medio (MSE) o el error absoluto medio (MAE).

Métricas de evaluación para modelos de clasificación

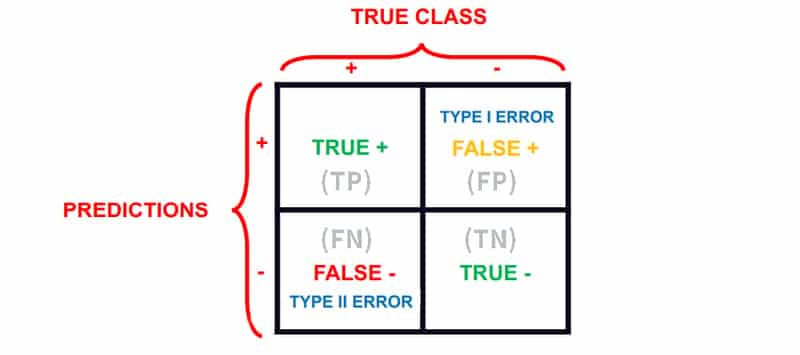

Para los modelos de clasificación, existen varias métricas estándar que se utilizan para medir la precisión y rendimiento. Cada una de estas métricas ofrece una perspectiva diferente sobre el rendimiento del modelo, y es crucial elegir la adecuada para el contexto específico del proyecto.

La exactitud es una de las métricas más comunes y se define como el número total de predicciones correctas dividido por el número total de predicciones realizadas. Sin embargo, la exactitud puede ser engañosa, especialmente en conjuntos de datos desbalanceados en los que una clase puede dominar. Por ello, métricas adicionales como la precisión y el recall deben ser consideradas. La precisión mide la cantidad de verdaderos positivos en comparación con todos los casos que el modelo predijo como positivos. El recall, por su parte, se centra en los verdaderos positivos en relación con el total de positivos reales, brindando una visión completa de cómo el modelo maneja las diferentes clases.

La F1-score es una métrica que combina precisión y recall en un único valor. Este es particularmente útil cuando se necesita un balance entre ambas métricas, lo cual es crítico en contextos donde tanto los falsos positivos como los falsos negativos tienen implicaciones significativas.

Métricas de evaluación para modelos de regresión

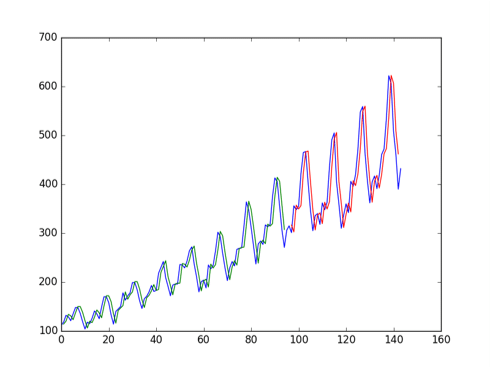

En los casos de regresión, donde se utilizan modelos para predecir un valor continuo, se implementan métricas diferentes a la hora de evaluar la precisión. Una de las métricas más utilizadas es el error cuadrático medio o MSE, que mide la media de los cuadrados de los errores, es decir, las diferencias cuadradas entre los valores previstos y los valores reales. Es particularmente sensible a los valores atípicos, lo que refleja su capacidad para mostrar una evaluación más estricta del rendimiento del modelo.

Otra métrica importante es el error absoluto medio o MAE, que calcula la media de los errores absolutos entre las predicciones y los valores reales. A diferencia del MSE, el MAE es más robusto a los valores atípicos y arroja una medida más clara de la desviación media de las predicciones.

También se emplea el R² (coeficiente de determinación) para entender qué proporción de la varianza de la variable dependiente es explicada por el modelo. Un R² elevado sugiere que el modelo está proporcionando una buena estimación de los resultados reales, mientras que un valor bajo puede indicar que el modelo no está capturando bien las tendencias de los datos.

Evaluación cruzada: Un enfoque eficaz

La evaluación cruzada es un enfoque que se utiliza comúnmente para obtener una estimación más precisa de la capacidad de generalización de un modelo. En lugar de entrenar y evaluar el modelo en el mismo conjunto de datos, la evaluación cruzada divide el conjunto de datos en múltiples particiones y entrena el modelo en cada partición, utilizando las demás para evaluar su rendimiento. Uno de los métodos más comunes es la validación cruzada k-fold, donde el conjunto de datos se divide en k subconjuntos, y el modelo se entrena k veces, cada vez usando un subconjunto diferente como conjunto de prueba.

Este método no solo ayuda a minimizar la varianza de las estimaciones de rendimiento, sino que también permite una mejor utilización de los datos disponibles y evita el sobreajuste, lo que es crítico en situaciones donde los datos pueden ser limitados.

Interpretación de resultados y su importancia

La interpretación adecuada de las métricas de precisión es esencial, ya que puede influir en las decisiones estratégicas dentro de una organización. Un modelo con alta precisión no necesariamente se alinea con los objetivos comerciales; se debe comprender en qué contexto esas métricas están siendo aplicadas. Por ejemplo, un alto valor de precisión en un modelo de detección de fraude puede ser deseable, pero también debe complementarse con un análisis del contexto en el que se está operando.

La comparación de métricas de diferentes modelos también es importante. A menudo, se requiere realizar un análisis comparativo para elegir el modelo más adecuado para un problema particular, entendiendo cómo cada métrica se relaciona con los resultados deseados. El uso de un gráfico de curva ROC (Receiver Operating Characteristic) puede facilitar este análisis, ya que permite visualizar de forma clara el rendimiento de varios modelos en diferentes umbrales de decisión.

Conclusiones y reflexión final

La medición de la precisión en los resultados de machine learning es un tema amplio y matizado. Comprender las distintas métricas disponibles, como la exactitud, precisión, recall, F1-score, MSE y MAE, así como la importancia de la evaluación cruzada, es fundamental para asegurar que los modelos sean efectivamente útiles en un entorno real. Esta comprensión no solo permite ajustar y mejorar los modelos sino que también respalda decisiones informadas en la implementación de soluciones basadas en datos.

Saber cómo medir la precisión de un modelo va más allá de simplemente aplicar fórmulas y métricas; se trata de adoptar un enfoque holistic que contemple la naturaleza del problema, los datos asociados y los resultados deseados, todo ello en un contexto que responsabilice así el impacto que estos modelos pueden tener en la sociedad y en el negocio. El avance en el campo del machine learning continúa y, con ello, la necesidad de comprender y refinar nuestras herramientas para medir el éxito de manera efectiva.

Si quieres conocer otros artículos parecidos a Medición de la precisión en resultados de Machine Learning puedes visitar la categoría Machine Learning.

Deja una respuesta