Normalización en reducción de datos y su relevancia en análisis

En el mundo del análisis de datos, donde la información abunda y las variables parecen infinitas, la normalización juega un papel crucial para asegurar que los datos sean consistentes y significativos. La normalización de los datos es un proceso que transforma diferentes escalas y tipos de datos en una forma uniforme, facilitando la comparación y el análisis. A medida que las organizaciones buscan tomar decisiones informadas basadas en datos, comprender y aplicar métodos de normalización se convierte en una habilidad esencial.

Este artículo se propone explorar los diversos aspectos de la normalización en reducción de datos y su relevancia en el análisis. Abordaremos qué es la normalización, los diferentes métodos utilizados, sus aplicaciones prácticas y por qué es fundamental en el contexto del análisis de datos. Con esta guía, esperamos ofrecer una comprensión profunda sobre cómo la normalización impacta en la calidad de los análisis que realicen las organizaciones y cómo puede ayudar a mejorar la precisión de los resultados obtenidos.

Qué es la normalización en el contexto de datos

La normalización de datos se refiere al proceso de ajustar los valores de los datos para que se enmarquen dentro de una escala común, sin distorsionar las diferencias en los rangos de valores. Esto es especialmente importante cuando se trabaja con datos que provienen de varias fuentes, en los cuales las variables pueden tener diferentes unidades de medida o escalas. Al aplicar la normalización, los analistas pueden asegurar que los modelos estadísticos y algoritmos de aprendizaje automático no se vean influenciados de manera desproporcionada por variables con rangos más amplios.

Hay varias razones por las que se necesita la normalización en el análisis de datos. En primer lugar, sin la normalización, las mediciones con un rango mayor pueden dominar otras variables con unidades menores, afectando la interpretación de los resultados. Además, los modelos de aprendizaje automático a menudo se benefician de la normalización, mejorando la rapidez y efectividad del entrenamiento de los modelos. Sin embargo, es fundamental elegir el método de normalización adecuado según el tipo de variable y los objetivos del análisis.

Métodos de normalización de datos

Existen varios métodos que se pueden usar para normalizar los datos, cada uno con sus propias ventajas y desventajas. Uno de los métodos más comunes es la escala mínimo-máximo, que reescala las características para que tomen un rango específico, normalmente entre 0 y 1. Este método es útil cuando se desea preservar las relaciones proporcionales entre los diferentes valores de las variables. Sin embargo, una desventaja es que puede ser sensible a los valores atípicos, lo que puede distorsionar la normalización.

Otro método popular es la normalización Z, que transforma los datos a una distribución estándar con una media de cero y una desviación estándar de uno. Esto es particularmente ventajoso para los análisis que asumen que los datos siguen una distribución normal. La normalización Z permite la comparación de variables que pueden tener diferentes unidades de medida, pero también puede resultar un poco menos intuitiva cuando se interpretan los valores, ya que sus unidades no corresponden a las originales.

Además, la normalización robusta es una técnica de normalización que utiliza el rango intercuartílico para reducir el efecto de los valores atípicos. Esto hace que la normalización robusta sea ideal para conjuntos de datos que contengan muchas anomalías. Sin embargo, es crucial que los analistas consideren el contexto de los datos y los objetivos del análisis antes de elegir el método de normalización más adecuado.

Aplicaciones prácticas de la normalización en análisis de datos

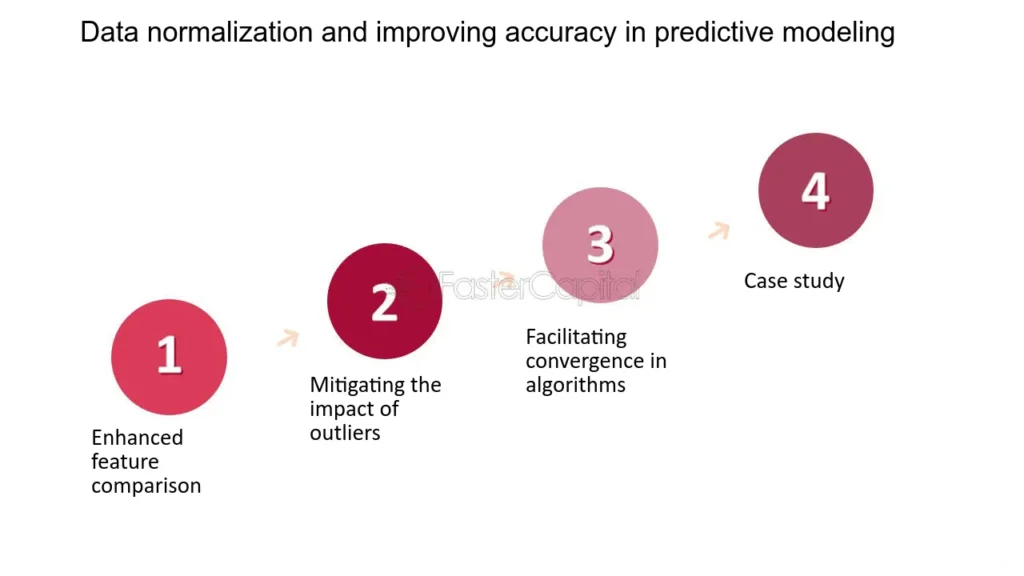

La aplicación de la normalización es extensa y abarca diversas áreas del análisis de datos, incluyendo la minería de datos, el aprendizaje automático y el desarrollo de modelos predictivos. En el contexto de la minería de datos, la normalización permite a los algoritmos de clustering agruparse en categorías y patrones de forma más efectiva. Al reducir el sesgo introducido por las diferencias en la escala de las variables, los analistas pueden descubrir insights valiosos que de otra manera pasarían desapercibidos.

Por su parte, en el aprendizaje automático, la normalización es esencial para optimizar el rendimiento de los modelos. Algoritmos como la regresión logística o las redes neuronales pueden requerir datos normalizados para evitar problemas de convergencia y mejorar la precisión del modelo. Cuando los datos no están normalizados, puede que se necesiten más iteraciones y tiempo computacional, lo que puede resultar en un análisis menos eficiente.

Además, las técnicas de normalización son especialmente útiles en aplicaciones de procesamiento de imagen y reconocimiento de patrones, donde las diferencias en la luminancia o el color pueden hacer que ciertos elementos sean difíciles de identificar. La normalización de las características de las imágenes ayuda a mejorar el rendimiento de los modelos, proporcionando una representación más homogénea de los datos. Por lo tanto, la normalización no solo aumenta la calidad del análisis, sino que también aporta a la eficiencia operativa y al uso efectivo de recursos computacionales.

La relevancia de la normalización en el análisis de datos

Entender la normalización en reducción de datos es de extrema importancia para cualquier profesional que trabaje con datos hoy en día. La calidad de los datos influye directamente en la calidad del análisis y, por lo tanto, en la calidad de las decisiones empresariales que se derivan de dicho análisis. La normalización actúa como un primer paso crucial que no solo mejora la comparabilidad de datos, sino que también juega un papel fundamental en la preparación de los datos para el análisis posterior.

Además, en un mundo donde el volumen y la complejidad de los datos continúan creciendo, la normalización ofrece un camino para la innovación y el avance de la inteligencia artificial. A medida que se desarrollan nuevas técnicas de análisis de datos y aprendizaje automático, la normalización seguirá siendo un componente esencial para garantizar que los modelos sean robustos y confiables. Por lo tanto, la falta de normalización podría conducir a decisiones erróneas, pérdidas financieras o, en el peor de los casos, fallos en la implementación de estrategias empresariales.

Conclusión

La normalización en reducción de datos es un proceso esencial que impacta profundamente en la calidad y efectividad del análisis de datos. Al comprender y aplicar adecuadamente las técnicas de normalización, los analistas podrán facilitar comparaciones significativas entre diferentes conjuntos de datos y mejorar la precisión de sus modelos. Cada uno de los métodos de normalización tiene sus ventajas y desventajas, y la elección adecuada puede hacer una diferencia considerable en los resultados finales. Mientras que el análisis de datos sigue evolucionando, la normalización se erige como un pilar fundamental que apoya la integridad del proceso de análisis. Al adoptar la normalización como parte de su enfoque analítico, los profesionales de datos pueden dar un paso significativo hacia la mejora del análisis y de las decisiones basadas en datos, contribuyendo así al éxito organizacional a largo plazo.

Si quieres conocer otros artículos parecidos a Normalización en reducción de datos y su relevancia en análisis puedes visitar la categoría Reducción.

Deja una respuesta