Qué es la normalización de datos en transcriptómica

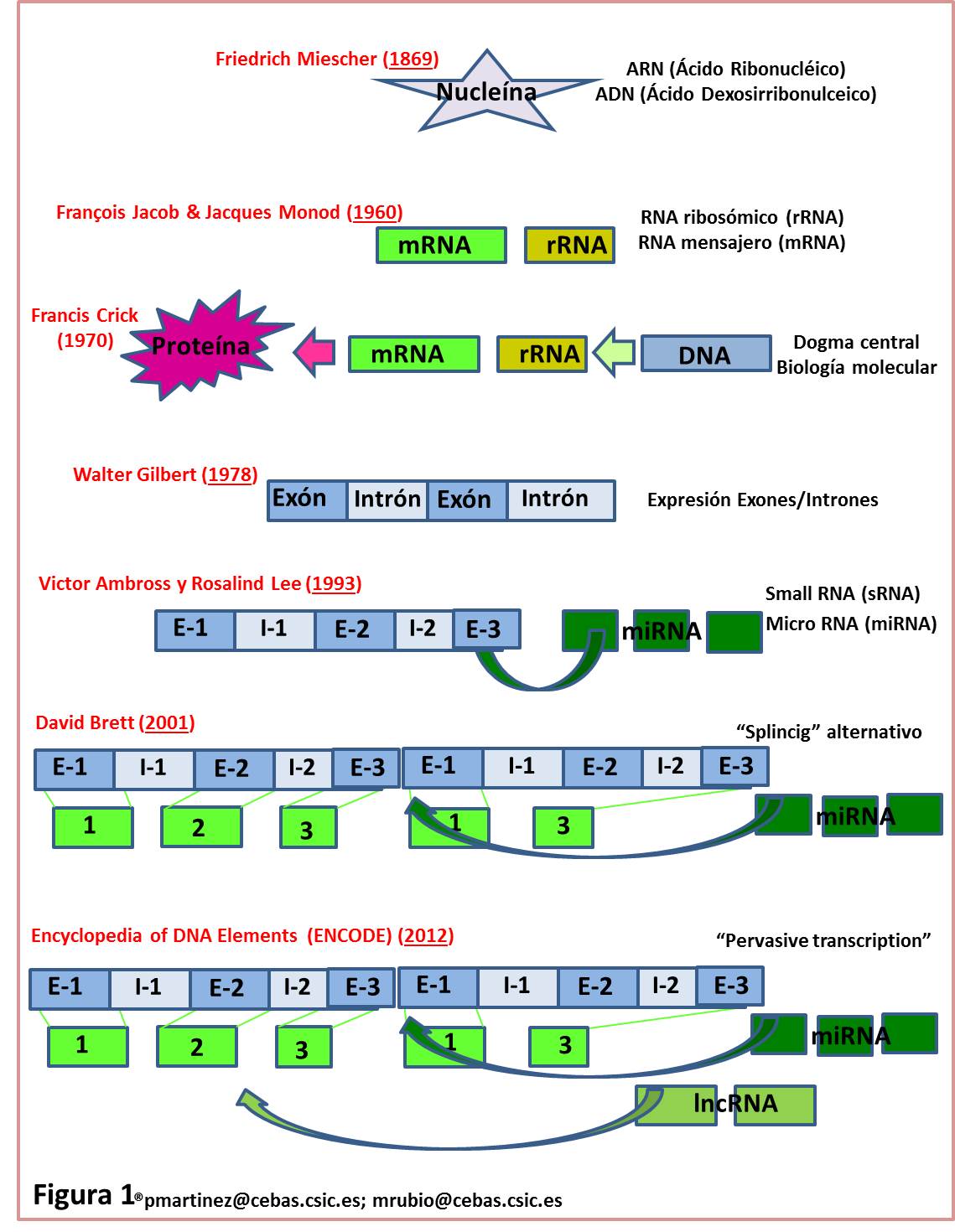

La normalización de datos en el ámbito de la transcriptómica es un tema fundamental para la comprensión y análisis de las variaciones en la expresión génica. Con el avance de la biotecnología y las técnicas avanzadas de secuenciación, se ha vuelto crucial interpretar correctamente los inmensos volúmenes de información obtenidos. La transcriptómica, que se centra en el estudio de los transcriptomas completos, se ha convertido en una herramienta esencial para descubrir cómo los genes se expresan en diferentes condiciones y cómo esas expresiones afectan fenómenos biológicos, desde el desarrollo de enfermedades hasta las respuestas a tratamientos específicos.

Este artículo se dedicará a explorar en profundidad qué es la normalización de datos en transcriptómica, por qué es crucial y cuáles son los métodos más utilizados para llevarla a cabo. A lo largo de este recorrido, examinaremos los principios subyacentes de esta técnica y su aplicación en investigaciones contemporáneas, enfatizando cómo la normalización puede mejorar la calidad de los análisis de datos y facilitar descubrimientos significativos en el campo de la biología molecular y genética.

- ¿Por qué es esencial la normalización de datos en transcriptómica?

- Métodos de normalización en transcriptómica

- Impacto de la normalización en el análisis de datos transcriptómicos

- Casos de estudio en normalización de datos transcriptómicos

- Desafíos en el proceso de normalización de datos

- Conclusión: La normalización de datos en el futuro de la transcriptómica

¿Por qué es esencial la normalización de datos en transcriptómica?

La normalización de datos es un proceso necesario que elimina o reduce las variaciones no biológicas que pueden afectar los resultados de un experimento. En el contexto de la transcriptómica, estas variaciones pueden surgir de diversas fuentes, como diferencias en la eficiencia de la extracción de ARN, variaciones en la calidad de las muestras, efectos de batch (lotes) y diferencias en los métodos de secuenciación. Sin una normalización adecuada, los datos crudos pueden llevar a interpretaciones erróneas; por ejemplo, podríamos concluir que un gen está sobreexpresado en una condición determinada, cuando en realidad, la variación observada podría deberse a artefactos técnicos.

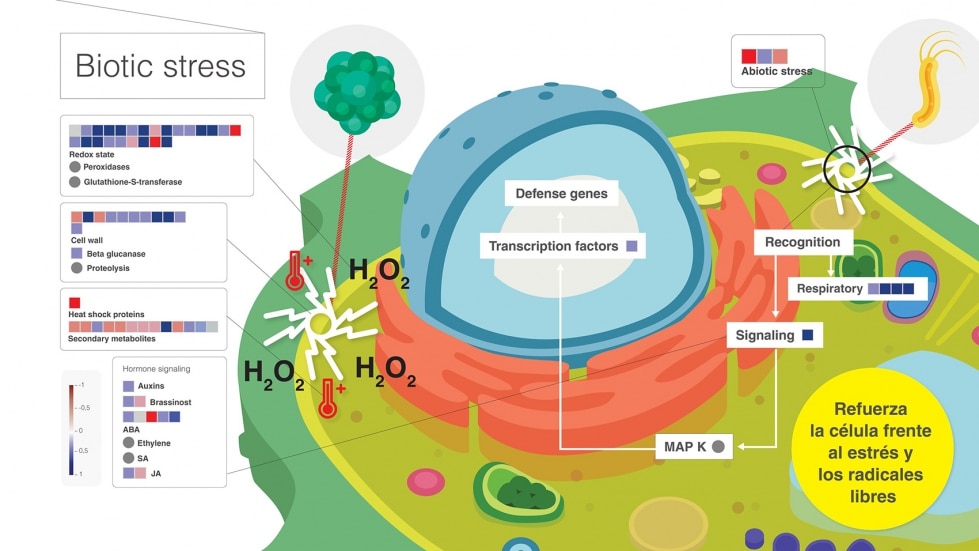

A lo largo de los estudios de expresión génica, se han documentado diversos sesgos que afectan la cuantificación de los niveles de RNA a partir de los datos de secuenciación. La normalización busca corregir estas distorsiones, asegurando que los datos obtengan una representación precisa de la biología subyacente. Esto es particularmente importante cuando se comparan múltiples condiciones o tratamientos, ya que las diferencias observadas deben reflejar cambios biológicos reales y no artefactos experimentales.

Métodos de normalización en transcriptómica

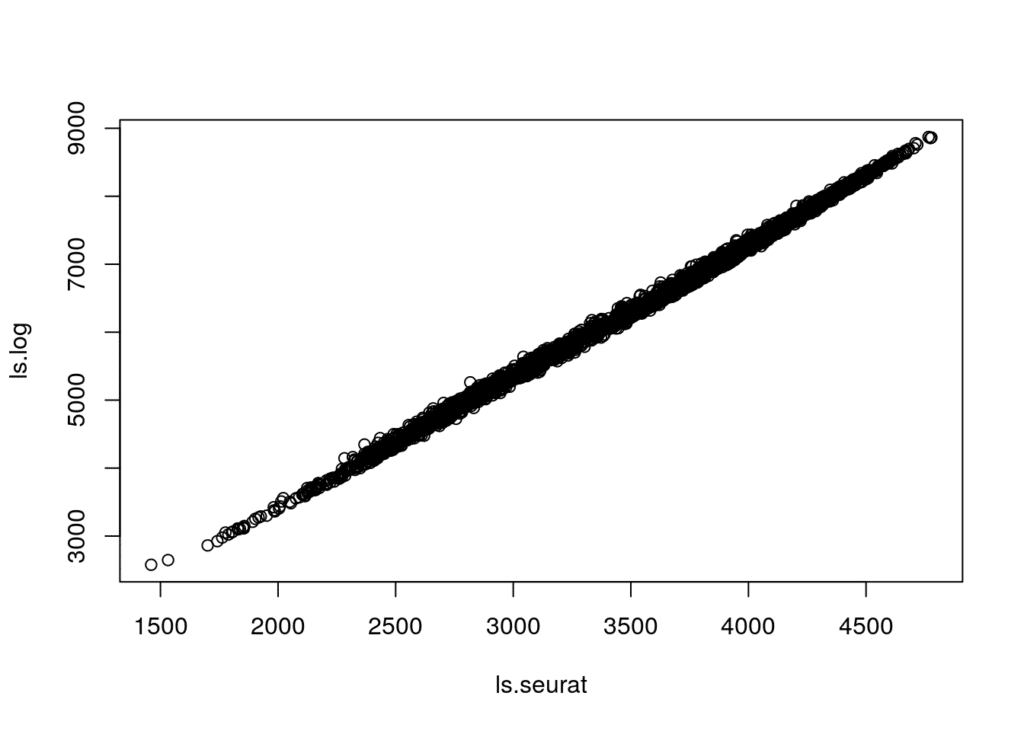

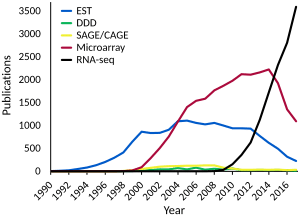

A lo largo de los años, se han desarrollado varios métodos para realizar la normalización de datos en transcriptómica. Cada uno de ellos tiene sus propias ventajas y desventajas, y su elección puede depender del diseño del experimento y los objetivos de la investigación. Uno de los métodos más comunes es el ajuste por cuenta total. Este enfoque implica dividir las cuentas de cada gen en una muestra por el número total de lecturas generadas en esa misma muestra, lo que permite que las comparaciones se realicen en una escala común.

Otro método frecuentemente utilizado es la normalización por medio de la media geométrica, que tiene en cuenta la expresión de todos los genes para establecer un punto de referencia. Este enfoque es particularmente útil cuando se desea ajustar los datos para minimizar el impacto de las variaciones extremas en los niveles de expresión, que pueden influir negativamente en el cálculo de las medias. Existen también métodos más avanzados, como el uso de factores de escala, que ajustan las cuentas de lectura para reflejar diferencias en la profundidad de la secuenciación y otros factores técnicos.

Impacto de la normalización en el análisis de datos transcriptómicos

La correcta normalización de datos tiene un impacto profundo en la interpretación de los resultados de los experimentos de transcriptómica. Por un lado, mejora la precisión de las comparaciones entre diferentes grupos, permitiendo a los investigadores identificar los genes que realmente están regulados bajo diversas condiciones. Al aplicar adecuadamente técnicas de normalización, los estudios pueden revelar patrones que, de otra forma, podrían quedar ocultos debido a sesgos técnicos.

Además, un análisis normalizado es vital para la integración de datos de diferentes fuentes o experimentos. En la era del big data, donde múltiples proyectos pueden compartir información, será crucial contar con datos que hayan sido normalizados usando metodologías que permitan su comparación. Este aspecto es esencial para seguir desarrollando bases de datos y recursos de referencia que faciliten la colaboración en el ámbito de la biología funcional y la medicina personalizada.

Casos de estudio en normalización de datos transcriptómicos

Numerosos estudios han demostrado la importancia de la normalización de datos en transcriptómica. Por ejemplo, un análisis realizado en células madre pluripotentes demostró cómo la correcta normalización permitió identificar nuevos marcadores de pluripotencia. En este estudio, los investigadores utilizaron un enfoque de normalización por decil para corregir las variaciones en los niveles de expresión antes de realizar un análisis de agrupamiento jerárquico. El resultado fue una agrupación más clara de las muestras, revelando subtipos que no se habrían identificado sin este ajuste.

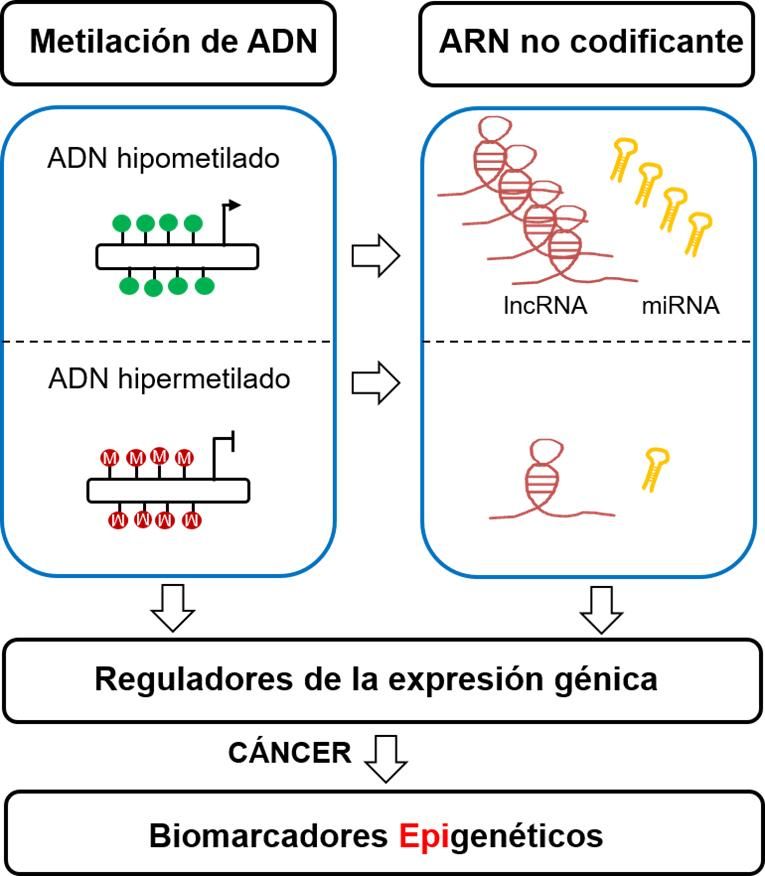

Otro caso relevante es el del cáncer, donde los perfiles de expresión génica de tumores pueden estar plenos de variaciones técnicas. La normalización de datos en estudios transcriptómicos de cáncer ha llevado a la identificación de vías de señalización claves que pueden ser perturbarse en diferentes tipos de cáncer. Esto ha permitido un avance significativo en las estrategias de tratamiento, enfocándose en dianas terapéuticas dirigidas y personalizadas.

Desafíos en el proceso de normalización de datos

A pesar de su importancia, la normalización de datos no está exenta de desafíos. Uno de los principales problemas es la elección del método adecuado, ya que cada conjunto de datos puede requerir un enfoque diferente. Las decisiones tomadas en esta etapa pueden infligir cambios significativos en los resultados finales y pueden afectar la interpretabilidad de los datos. Por otro lado, el uso de metodologías inapropiadas puede llevar a una sobre- o subnormalización, lo que paradójicamente puede introducir nuevos sesgos en lugar de corregir los existentes.

Un aspecto adicional que presenta dificultad es la heterogeneidad biológica, especialmente en muestras que provienen de tejidos complejos. La variabilidad en la expresión génica puede estar relacionada no solo con factores técnicos, sino también con condiciones biológicas intrínsecas. Así, los investigadores deben ser conscientes de la necesidad de desarrollar algoritmos sofisticados que tomen en cuenta estos matices al normalizar los datos.

Conclusión: La normalización de datos en el futuro de la transcriptómica

La normalización de datos en transcriptómica es un proceso crítico que no solo mejora la calidad de los resultados experimentales, sino que también permite comparaciones válidas entre diferentes estudios y condiciones. Sin esta etapa fundamental, los datos generados a través de técnicas avanzadas de secuenciación podrían llevar a conclusiones incorrectas que, en última instancia, obstaculizarían el avance de la investigación biomédica y la comprensión de las bases moleculares de las enfermedades.

A medida que la tecnología de secuenciación sigue evolucionando, también lo harán las técnicas de normalización de datos. El futuro promete el desarrollo de métodos más robustos y personales que tendrán en cuenta no solo las variaciones técnicas, sino también las características biológicas de las muestras, permitiendo que la transcriptómica continúe su trayectoria de innovación en el descubrimiento biológico y el desarrollo de nuevas terapias médicas.

Si quieres conocer otros artículos parecidos a Qué es la normalización de datos en transcriptómica puedes visitar la categoría Transcriptómica.

Deja una respuesta